ChatGPT的伦理问题:隐私、偏见与责任

ChatGPT的伦理问题:隐私、偏见与责任 随着人工智能技术的迅猛发展,以ChatGPT为代表的大型语言模型逐渐融入人们的日常生活和工作场景然而,在享受其带来的便利的同时,我们也不得不正视它所引发的一系列伦理问题,其中隐私、偏见与责任尤为突出。

一、隐私问题 数据收集与利用 ChatGPT等语言模型在训练过程中需要大量的语料数据这些数据可能来自各种公开或非公开的来源,包括互联网上的文本、社交媒体内容等在获取数据的过程中,如果缺乏严格的规范,就可能存在侵犯个人隐私的风险。

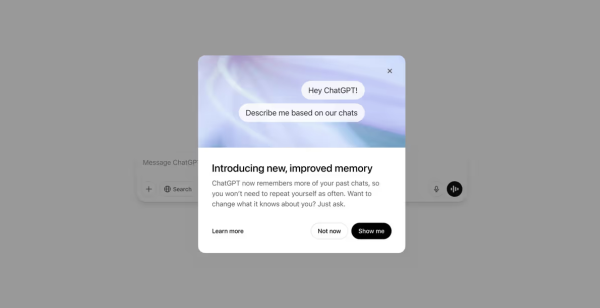

例如,一些用户在社交媒体上分享的看似无害的信息,一旦被纳入到训练数据中,就可能会被用于构建出能够生成涉及个人隐私信息回复的语言模型 当用户与ChatGPT交互时,聊天记录等交互数据也可能被保存下来用于改进模型或者进行其他用途。

如果没有明确告知用户数据的使用目的、范围以及存储方式,并且没有得到用户的充分同意,这将是对用户隐私权的严重侵犯比如,用户可能不知道自己的对话内容会被用来分析某些特定人群的行为模式,进而影响到自己未来的用户体验或者其他权益。

隐私保护的技术挑战 从技术角度来看,要确保在使用像ChatGPT这样的模型时完全保护隐私并非易事尽管有一些隐私保护技术如差分隐私等被提出,但要在不影响模型性能的前提下广泛应用仍然面临诸多困难例如,差分隐私可能会导致模型对输入数据的敏感度降低,从而影响到生成回复的质量。

而且,随着攻击手段的不断进化,如何防止通过模型输出来反向推测出输入中的隐私信息也是一个亟待解决的问题 二、偏见问题 训练数据中的偏见传递 由于ChatGPT是基于大量现有文本数据训练而成的,而这些文本数据本身可能存在各种各样的偏见。

例如,在社会历史进程中形成的性别偏见、种族偏见等会在网络文本中有所体现当模型学习到这些带有偏见的数据后,就会在生成文本时无意间将这种偏见延续下去比如,对于某些职业的描述可能会倾向于男性化或者女性化,这不仅不符合现代社会倡导的平等观念,还可能对人们的思想产生误导。

算法自身的局限性 模型的算法结构也可能会导致偏见的产生ChatGPT在处理复杂的语义关系时,可能会过度依赖某些特征或者模式,而这些特征或模式可能是与偏见相关的例如,在判断一个人的能力或者价值时,如果模型过于关注某些刻板印象中的因素,如外貌、地域等,就会得出有失公允的结论。

这种偏见可能会在招聘、教育评价等多个领域造成不公平的现象,限制了部分人的机会和发展空间 三、责任问题 开发者与使用者的责任划分 对于ChatGPT而言,开发者承担着重要的责任他们需要确保模型的设计、训练过程符合伦理道德标准。

例如,在选择训练数据时要进行严格的筛选,去除含有不良价值观或者明显偏见的内容;在模型架构设计上要考虑如何避免生成有害信息但是,使用者也不能完全置身事外使用者应该合理合法地使用该模型,不得利用它从事违法或者违背公序良俗的活动。

例如,不能用ChatGPT生成虚假信息进行诈骗或者恶意攻击他人 监管与追责机制 在当前的人工智能发展环境下,还需要建立完善的监管体系来明确各方的责任并进行有效的追责政府相关部门应该制定相应的法律法规,规定在出现由ChatGPT引发的侵权、传播不良信息等情况时,如何确定责任主体并给予相应的处罚。

同时,也需要行业内部建立自律机制,共同维护良好的使用环境例如,可以成立专门的委员会对ChatGPT等类似产品的开发和应用进行监督评估,及时发现并纠正存在的伦理问题 总之,ChatGPT等大型语言模型的伦理问题是一个复杂且亟待解决的问题。

只有在保障隐私、消除偏见、明确责任等方面共同努力,才能让这类技术更好地服务于人类社会的发展